Vidhi Chugh 2024-09-10

学习如何利用AUC-ROC曲线评估二分类模型的性能,重点关注模型在不同阈值下的表现,尤其是在类别不平衡的数据集中。我们将使用Python库计算AUC值,并在一个工作流中比较多个分类器。

分类模型是最常用的预测算法之一。我们可以使用多种算法对某一过程进行建模,但如何判断哪个模型效果最好呢?

模型选择涉及根据性能指标(如精确率、召回率、F1分数和AUC-ROC)来评估不同模型。虽然精确率、召回率和F1分数等指标可以提供关于哪个模型最适合数据的见解,但它们仅在单一阈值下有效。而AUC-ROC(即ROC曲线下面积,Area Under the Receiver Operating Characteristic Curve)是一种稳健的指标,它评估的是模型在整个阈值范围内的整体表现。

在本文中,我们将深入理解为何AUC-ROC是评估二分类模型性能的首选指标,以及如何利用它来区分两个类别。在开始之前,也建议你考虑报名参加我们的《Python机器学习科学家》职业路径课程。该课程将使你成为sklearn专家——我们将在本教程中全程使用这一库。

什么是ROC曲线?

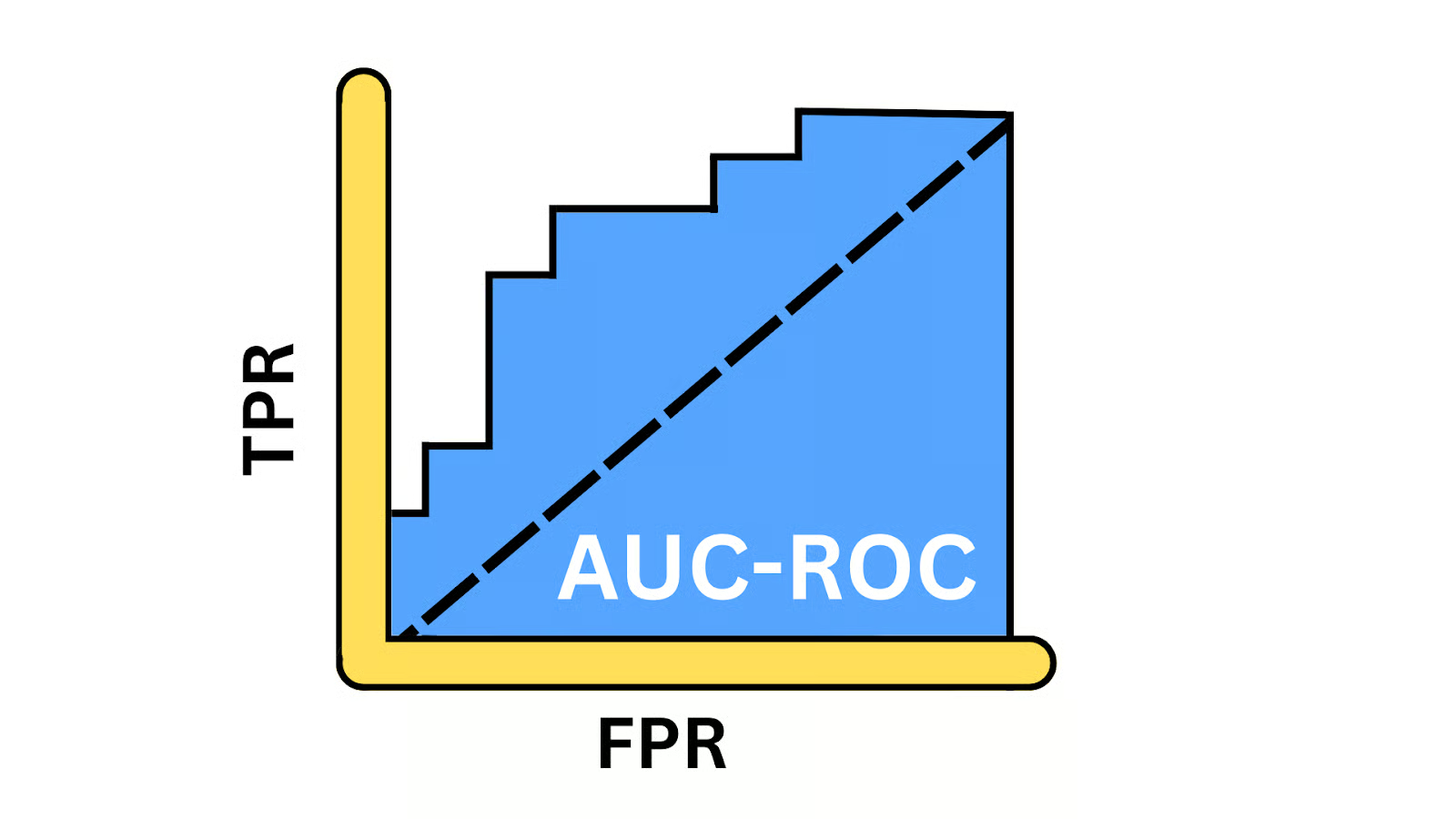

ROC曲线以图形方式展示了在不同阈值下真正例率(TPR)与假正例率(FPR)之间的权衡。它揭示了模型在不同阈值下平衡“正确识别正例”与“避免误报”的能力。AUC(曲线下面积)是一个介于0到1之间的标量值,用于概括模型的整体性能。只有在生成ROC曲线后才能计算AUC,因为AUC代表的就是该曲线下方的面积。

AUC-ROC曲线示意图。作者供图

真正例率(True Positive Rate, TPR)

真正例率,也称为敏感度或召回率,反映了模型正确识别正例的能力。它衡量的是实际为正例的样本中,被模型成功识别为正例的比例。数学表达式如下:

其中:

- TP(真正例):模型正确预测为正类的正类样本数量。

- FN(假负例):模型错误预测为负类的正类样本数量。

假正例率(False Positive Rate, FPR)

FPR表示模型将负类样本错误分类为正类的频率。它衡量的是实际为负例的样本中,被模型错误标记为正例的比例,反映了误报率。其数学表达式如下:

其中:

- FP(假正例):模型错误预测为正类的负类样本数量。

- TN(真负例):模型正确预测为负类的负类样本数量。

为何使用AUC-ROC曲线?

让我们了解AUC-ROC在哪些场景下更为适用。

性能度量

AUC-ROC提供了在所有可能分类阈值下的综合性能度量。与依赖特定阈值的准确率、精确率或F1分数不同,它考虑了模型在不同操作点上的表现。

模型比较

AUC-ROC是一个单一标量值,便于比较多个模型,无论它们的最佳阈值是否相同。其阈值无关的特性使其成为公平比较具有不同最优阈值模型的更好选择。

处理类别不平衡

大多数现实世界的数据集都是不平衡的,即某一类别的样本数量远多于另一类别,例如情感分析、欺诈检测和癌症筛查。在这些场景中,准确率等指标会因偏向多数类而产生误导性评估。此时,AUC-ROC等指标更为可靠。

AUC-ROC曲线的核心概念

让我们看看一些关键思想。

绘制ROC曲线

为了生成ROC曲线,我们需要在多个阈值下计算TPR和FPR。首先导入本演示所需的库:

from sklearn.model_selection import train_test_split

from sklearn.datasets import make_classification

from sklearn.linear_model import LogisticRegression

from sklearn.metrics import roc_auc_score, accuracy_score, precision_score, recall_score, f1_score, confusion_matrix, roc_curve, auc

import matplotlib.pyplot as plt

接下来,我们使用make_classification()函数生成一个包含1000个样本和20个特征的二分类数据集:

# 生成二分类数据集

X, y = make_classification(n_samples=1000, n_features=20, n_classes=2, random_state=0)

将数据集划分为训练集和测试集——我们将在训练集上训练模型,并在未见过的测试集上评估其性能:

# 划分训练集和测试集

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.3, random_state=0)

接着,通过调用LogisticRegression()类定义模型对象,并使用fit方法在训练数据上进行训练,其中X_train包含特征,y_train为标签:

# 训练逻辑回归模型

model = LogisticRegression()

model.fit(X_train, y_train)

现在模型已训练完成,可以生成预测结果。我们调用predict_proba()函数获取正类的概率,使用predict()方法计算准确率、精确率、召回率和F1分数等评估指标:

# 预测测试集的概率

y_probs = model.predict_proba(X_test)[:, 1]

# 预测测试集的类别

y_pred = model.predict(X_test)

接下来,使用各自的函数计算并打印这些指标:

# 计算AUC-ROC分数

roc_auc = roc_auc_score(y_test, y_probs)

# 计算其他指标

accuracy = accuracy_score(y_test, y_pred)

precision = precision_score(y_test, y_pred)

recall = recall_score(y_test, y_pred)

f1 = f1_score(y_test, y_pred)

# 打印指标

print(f"AUC - ROC Score: {roc_auc:.2f}")

print(f"Accuracy: {accuracy:.2f}")

print(f"Precision: {precision:.2f}")

print(f"Recall: {recall:.2f}")

print(f"F1 Score: {f1:.2f}")

输出结果:

AUC - ROC Score: 0.93

Accuracy: 0.87

Precision: 0.87

Recall: 0.87

F1 Score: 0.87

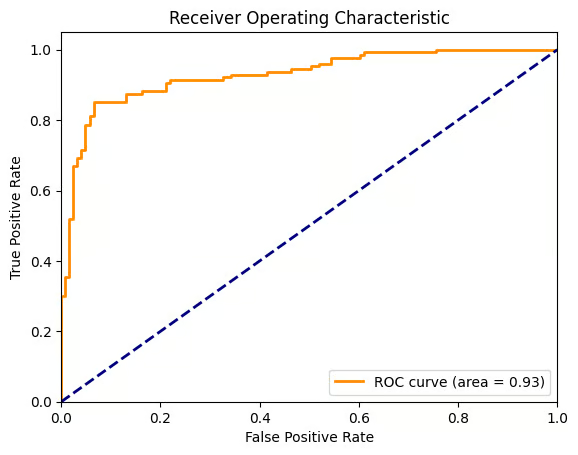

现在,让我们可视化ROC曲线,并添加一条对角线表示随机猜测模型的表现。为此,我们需要计算0到1之间每个离散阈值对应的FPR和TPR。下图中,橙色曲线代表ROC曲线,其下方面积为0.93。

# 绘制ROC曲线

fpr, tpr, thresholds = roc_curve(y_test, y_probs)

roc_auc = auc(fpr, tpr)

plt.figure()

plt.plot(fpr, tpr, color='darkorange', lw=2, label=f'ROC curve (area = {roc_auc:.2f})')

plt.plot([0, 1], [0, 1], color='navy', lw=2, linestyle='--')

plt.xlim([0.0, 1.0])

plt.ylim([0.0, 1.05])

plt.xlabel('False Positive Rate')

plt.ylabel('True Positive Rate')

plt.title('Receiver Operating Characteristic')

plt.legend(loc="lower right")

plt.show()

逻辑回归的ROC曲线。作者供图

使用ROC曲线选择最佳算法

现在,我们使用相同的数据集,通过ROC曲线比较四种分类算法的性能。首先导入RandomForestClassifier、KNeighborsClassifier和SVC,并与LogisticRegression进行比较:

from sklearn.ensemble import RandomForestClassifier

from sklearn.neighbors import KNeighborsClassifier

from sklearn.svm import SVC

# 定义模型

models = {

"Logistic Regression": LogisticRegression(),

"Random Forest": RandomForestClassifier(),

"SVM": SVC(probability=True),

"K-Nearest Neighbors": KNeighborsClassifier()

}

# 初始化字典以存储AUC-ROC分数

roc_auc_scores = {}

# 绘制ROC曲线

plt.figure(figsize=(10, 8))

for name, model in models.items():

# 训练模型

model.fit(X_train, y_train)

# 预测概率

y_probs = model.predict_proba(X_test)[:, 1]

# 计算AUC-ROC分数

roc_auc = roc_auc_score(y_test, y_probs)

roc_auc_scores[name] = roc_auc

# 计算ROC曲线

fpr, tpr, _ = roc_curve(y_test, y_probs)

# 绘制ROC曲线

plt.plot(fpr, tpr, lw=2, label=f'{name} (AUC = {roc_auc:.2f})')

# 绘制对角线(随机模型)

plt.plot([0, 1], [0, 1], color='navy', lw=2, linestyle='--')

# 自定义图表

plt.xlim([0.0, 1.0])

plt.ylim([0.0, 1.05])

plt.xlabel('False Positive Rate')

plt.ylabel('True Positive Rate')

plt.title('ROC Curve Comparison')

plt.legend(loc="lower right")

plt.show()

# 打印各模型的AUC-ROC分数

for name, score in roc_auc_scores.items():

print(f'{name}: AUC - ROC = {score:.2f}')

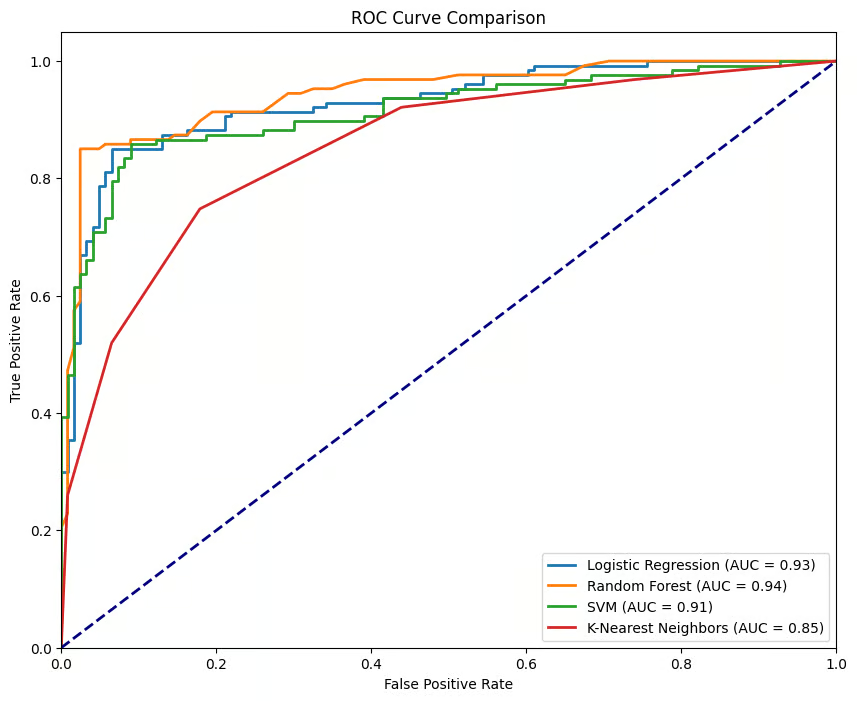

对于每个模型对象,我们都重复执行fit()和predict_proba(),计算对应的FPR和TPR,并绘制各自的曲线。

不同模型的ROC曲线。作者供图

上图显示了四个分类器对应的四条曲线,其中RandomForestClassifier表现最佳,AUC-ROC为0.94,而KNeighborsClassifier表现最差,AUC-ROC为0.85。理想模型的曲线应紧贴左上角——即TPR最大化、FPR最小化。曲线越接近该点,模型性能越好。

如何解读和理解AUC-ROC曲线

让我们分解AUC-ROC曲线提供的指标并理解其意义。

解读AUC值

AUC值可快速反映模型的性能水平:

- AUC接近1:模型表现极佳,具有很强的类别区分能力。

- AUC约为0.5:模型表现堪忧,与随机猜测无异,缺乏判别力。

- AUC接近0:情况严重,模型表现甚至不如抛硬币,完全颠倒了预测结果。

真正例率:衡量成功

TPR(敏感度)是关键指标,反映模型捕捉正例的能力。它计算的是实际正例中被正确识别的比例,是衡量模型识别“真正信号”有效性的核心指标。高TPR意味着模型在识别关键正例方面表现出色。

假正例率:衡量噪声

另一方面,FPR帮助我们理解“噪声”——即模型将负例误判为正例的频率。FPR是实际负例中被错误标记为正例的比例,是评估模型权衡的关键指标。高FPR表明模型容易产生误报,在某些应用场景中可能代价高昂。

平衡敏感度与特异度

二分类的魅力与挑战在于阈值设置,因此我们可以通过调整阈值来微调模型的敏感度(TPR)和特异度(1 - FPR)。在大多数现实场景中,漏报(假负例)与误报(假正例)的成本差异显著。

AUC-ROC曲线的实际应用案例

AUC-ROC不仅是一个理论概念,它在各行业中驱动着关键决策:

医疗诊断

AUC-ROC用于比较不同诊断测试的效果。当假负例(如漏诊疾病)的代价远高于假正例(如不必要的治疗)时尤其有用。典型例子是癌症筛查,可根据风险因素和资源可用性调整进一步检测的阈值。

欺诈检测

机器学习模型越来越多地用于识别金融领域的欺诈行为。由于欺诈交易极为罕见,此类数据集高度不平衡。因此,AUC-ROC是一种有效的评估指标,还可根据交易风险程度、人工核查成本及客户不便成本等因素调整阈值。

网络安全

与欺诈检测类似,网络攻击也是相对罕见事件。因此,AUC-ROC也应用于网络安全领域,在检测威胁与避免因误报导致的“警报疲劳”之间取得平衡。

AUC-ROC曲线的替代方案

AUC-ROC是评估二分类模型的流行指标,但在某些场景下,其他指标可能更合适。让我们探讨一些替代方案及其适用场景:

精确率-召回率曲线(Precision-Recall Curve, PRC)

PRC适用于类别极度不平衡且假正例与假负例成本不同的场景。与AUC-ROC在不平衡数据集中可能给出过于乐观的评估不同,PRC更关注正类的性能表现。

F1分数

F1分数是精确率与召回率的调和平均数,提供了一个平衡两者的单一指标。当我们需要一个清晰、简洁的模型性能摘要(尤其在不平衡数据集中)时非常有用。AUC-ROC提供全局视角,而F1分数则是PRC曲线上的一个特定点。

结论

AUC-ROC是二分类问题中的黄金标准,因为它提供了模型在不同阈值下表现的更均衡视图,尤其适用于类别不平衡的场景。

我们相信,动手实践是巩固学习的最佳方式。Python的灵活性为我们掌握核心概念提供了绝佳机会。无论你是复习基础知识,还是探索更高级的主题,现在都是深入实践AUC-ROC并挑战复杂数据集的理想时机。